为避免被英伟达单方面牵制,亚马逊云服务部门正考虑使用AMD最新AI芯片

来源:AICG工具箱 责编:网络 时间:2025-06-04 13:59:29

6月14日报道丨当地时间6月13日,AMD更新了旗下一款名为Instinct MI300的数据中心APU加速处理器的更多参数细节,该芯片旨在帮助处理人工智能相关的数据流量,并挑战英伟达的垄断地位。同时,亚马逊云服务(AWS)也在考虑使用AMD的人工智能芯片来提高其云服务的质量。虽然英伟达也提供整体系统DGX Cloud供云供应商使用,但是AWS并不打算采用该系统,而是更愿意从头开始设计自己的服务器。

亚马逊云服务(AWS)是全球最大的云计算供应商,该公司的一位高管近日接受媒体采访时透露,其正在考虑使用 AMD 的新型人工智能芯片,不过公司还没有做出最终的决定。

据悉,AMD已经在今年5月底的台北COMPUTEX 2023大会上提前公布了一些关于Instinct MI300 APU的技术规格,显示其今年晚些时候推出的这款人工智能芯片在某些指标上可以超过英伟达目前最好的产品,但是AMD目前并未对外披露采购该APU的企业。

AMD Instinct MI300是一款针对机器学习和人工智能应用而设计的高性能计算处理器。它采用了64位ARM A57核心,支持PCIe 4.0、Wi-Fi 6E以及高速存储接口,具有出色的性能和能效比。此外,AMD Instinct MI300还集成了AMD Radeon Vega Graphics显卡,可提供强大的图形处理能力,适用于深度学习和其他复杂的图像和视频处理任务。

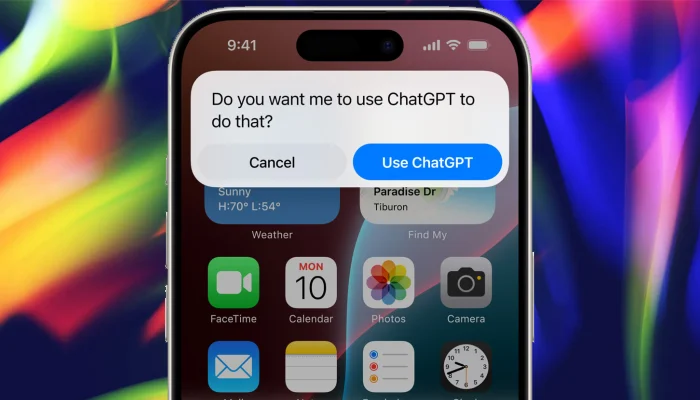

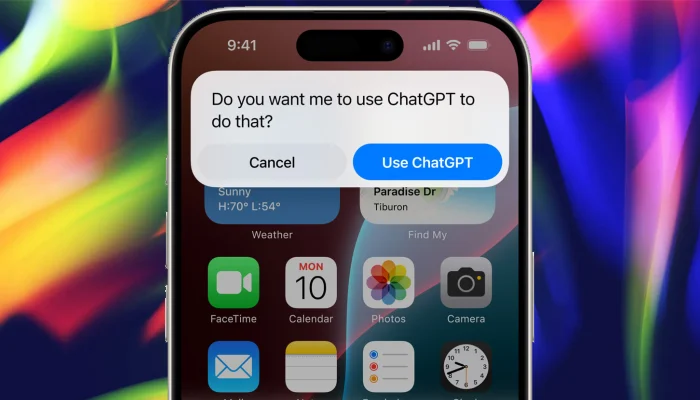

AMD CEO苏姿丰在接受采访时概述了一种赢得更多云计算客户的方法,即提供构建类似于 ChatGPT 这样的服务所需的所有部件,但让客户自己选择想要哪些部件,使用行业标准的连接方式。她说:“我们认为很多企业会需要更多的解决方案,他们会想要在搭建的数据中心里定制他们需要的设备。”

尽管AWS没有公开承诺使用AMD的新款Instinct MI300芯片来支持其云服务,但AWS弹性计算云副总裁戴夫・布朗表示,AWS确实有在考虑使用该芯片。他说:“我们还在和AMD一起努力,看看能落实到什么程度,我们的团队正在合作推进,看看在架构设计层面能否带来更多有益的帮助,将APU能够插入现有的AWS系统。”

英伟达虽然也会单独出售其芯片,但也在为云供应商提供一种由英伟达设计的整体系统,叫做 DGX Cloud,甲骨文公司是英伟达这种系统的第一个合作伙伴。布朗表示,AWS不考虑英伟达的DGX Cloud服务,他说:“他们找过我们,我们看了看商业模式,他们直接整包卖数据中心,我们觉得没有太大意义。”

布朗说,AWS更喜欢从头开始设计自己的数据中心。AWS从今年3月开始购买英伟达的H100显卡,作为自己设计的服务器系统的一部分。

- 常用AI 共 188 款

- 工具箱 共 218 款

- 最新消息 共 1907 款

-

TensorRT插件安装_TensorRT插件怎么提升SD生图速度_stable diffusion插件

本地SD部署速度一直被大家诟病,本次视频就给大家分享Tensorrt插件是如何秒变“5090”,让你的显卡生图速度提升4倍!

-

神州问学深入大模型微调技术研究,小参数的模型在特定任务场景中表现超越大模型

在这个时代里,不是模型越大越好,而是更加贴合实际应用场景的小型化、定制化模型正在成为主流。

-

DeepL推出新一代翻译编辑大模型:翻译质量超越竞争对手谷歌微软ChatGPT

DeepL 发布了新一代面向翻译和编辑应用的大型语言模型。据 DeepL 官方称,该模型在翻译质量和流畅度方面均优于当前市场上的其他竞争对手。

-

落地发绿卡?微软加速AI团队撤出中国,加码布局投资东南亚市场

关于微软撤离中国AI团队这件事,或许早有预兆。目前,在AI研究方面,微软正在对中国区的员工进行一定的技术“隔离”。

-

TensorRT插件安装_TensorRT插件怎么提升SD生图速度_stable diffusion插件

11 2025-05-08 -

阿里“通义听悟”升级:支持6小时超长视频内容解析提问,还可一键生成巨幅思维导图

5 2025-04-20

-

苹果与OpenAI合作,发布新版Siri与生成式AI功能丨马斯克宣布将禁用iPhone丨OpenAI百万年薪挖角谷歌芯片人才

16 2025-02-25

-

华为HDC 2024大会将发布盘古大模型5.0丨谷歌Gemini手机版将迎来多项功能更新丨马斯克xAI计划融资60亿美元

5 2025-04-14

-

苹果WWDC定档6月10日将发布AI战略丨中国时报:苹果与百度尚未达成AI合作丨抖音发布AI数字人治理公告

9 2025-04-18

-

OpenAI CEO奥特曼最新讲话汇总,再次曝光GPT-5细节:性能飞跃超乎想象,低估它的人都会被吓傻

5 2025-04-20 -

李开复:最好的AI大模型已经达到人类平均智商的三倍,“杀手级应用”已经出现

3 2025-04-20

-

重磅!英伟达正式官宣「AI核弹级」芯片B100,性能比H100强两倍的H200将于2024年第二季度出货

3 2025-04-20

-

面对Sora训练数据来源一问三不知!OpenAI遭遇成立以来最为惨烈的公关灾难

4 2025-04-20

-

英伟达发布AI算力芯片B200丨高通发布第三代骁龙8s处理器丨李开复:目前最好的大模型已达人类平均IQ的三倍

3 2025-04-20