性能是上一代10倍!!英伟达发布DGX GH200超级计算机

来源:AICG工具箱 责编:网络 时间:2025-06-11 17:00:07

5月30日报道丨当地时间5月29日上午,英伟达今天在 Computex2023 台北电脑展大会上发布了多项重磅消息,其中最引人注目的是其名为Grace Hopper(缩写 GH 系列)的超级算力芯片已经全面投产。英伟达创始人兼 CEO 黄仁勋在 NVIDIA 的演讲中宣布,生成式 AI 引擎NVIDIA DGX GH200 现已投入量产。

英伟达官网显示,NVIDIA DGX GH200 是将 256 个 NVIDIA Grace Hopper 超级芯片完全连接到单个 GPU 中的新型AI超级计算机,支持万亿参数AI大模型训练。能够处理大规模推荐系统、生成式人工智能和图形分析,并为巨型人工智能模型提供线性可扩展性。“不需要把数据储存在很多个模块中,DGX GH200 更易训练大语言模型、深度学习推荐系统。”黄仁勋称。

据悉,Grace Hopper 超级芯片是英伟达开发的基于 ARM 架构开发的 CPU+GPU 集成方案,它将 72 核的 Grace CPU、Hopper GPU、96GB 的 HBM3 和 512 GB 的 LPDDR5X 集成在同一个封装体系中,合计多达 2000 亿个晶体管。这种组合提供了 CPU 和 GPU 之间惊人的数据带宽,高达 1TB/s的吞吐量。英伟达称这种结构提供了比前一代系统高出 10 倍的 GPU 到 GPU 和 7 倍的 CPU 到 GPU 的带宽。它还设计了提供比竞争对手高出 5 倍的互连功耗效率和高达 128TB/s 的对分带宽。

NVIDIA 提供了 DGX GH200 的预计基准测试,其中 NVLink 交换机系统与与 InfiniBand 捆绑在一起的 DGX H100 集群正面交锋。NVIDIA 在上述工作负载计算中使用了不同数量的 GPU,范围从 32 到 256,但每个系统在每次测试中都使用了相同数量的 GPU。

DGX GH200 附带的优化的操作系统和集群管理器,使得管理大规模语言模型训练的复杂性大大降低。按照老黄的说法:花费 1000 万美金成本,你可以建置一个有 960 颗 CPU 核心的数据中心,但这个数据中心要 11GWh 的功率,处理 1X LMM 大语言模型的数据量。

DGX GH200 还具有非常灵活的扩展性和配置选项。用户可以根据自己的需求选择 GPU、内存、存储、网络等组件,并随时添加更多的资源,实现弹性扩展。

集成 256 个 GH200 芯片的 DGX GH200 超级计算机,内存扩大了 500 倍,超级算力提高了 7 倍,这个是相当了不起的成果,不出所料的话,英伟达的营收会随着超级计算机的诞生,获得更多的合同和利润,股价继突破万亿后,也会继续水涨船高。

- 常用AI 共 188 款

- 工具箱 共 218 款

- 最新消息 共 2045 款

-

谷歌Gemini文生图翻大车:生成人像过度追求种族多元性,涉嫌“歧视白人”,这可能是马斯克被“黑”得最惨的一次

近日,谷歌又摊上了美国社会最敏感的「种族政治正确」问题,这一次,追求多元性的谷歌,没有惹恼有色人种,而是惹到了白人族群。Gemini 1 5生成历史人物的图像,竟然诞生了一个平行时空的荒诞感十足的新宇宙。?

-

TensorRT插件安装_TensorRT插件怎么提升SD生图速度_stable diffusion插件

本地SD部署速度一直被大家诟病,本次视频就给大家分享Tensorrt插件是如何秒变“5090”,让你的显卡生图速度提升4倍!

-

神州问学深入大模型微调技术研究,小参数的模型在特定任务场景中表现超越大模型

在这个时代里,不是模型越大越好,而是更加贴合实际应用场景的小型化、定制化模型正在成为主流。

-

DeepL推出新一代翻译编辑大模型:翻译质量超越竞争对手谷歌微软ChatGPT

DeepL 发布了新一代面向翻译和编辑应用的大型语言模型。据 DeepL 官方称,该模型在翻译质量和流畅度方面均优于当前市场上的其他竞争对手。

-

TensorRT插件安装_TensorRT插件怎么提升SD生图速度_stable diffusion插件

11 2025-05-08 -

阿里“通义听悟”升级:支持6小时超长视频内容解析提问,还可一键生成巨幅思维导图

5 2025-04-20

-

MJ怎么批量出图_怎么用MJ批量生图

56 2025-01-27

-

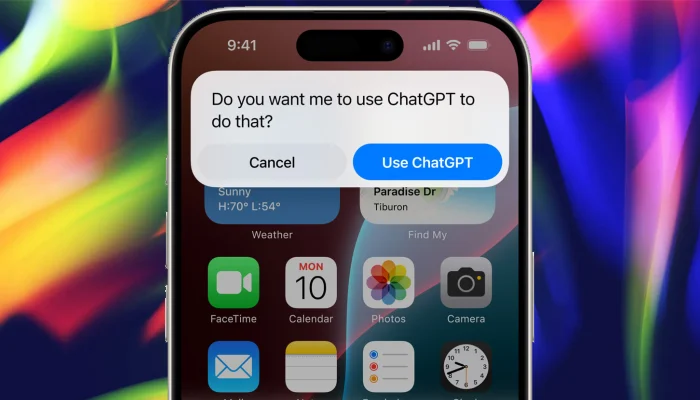

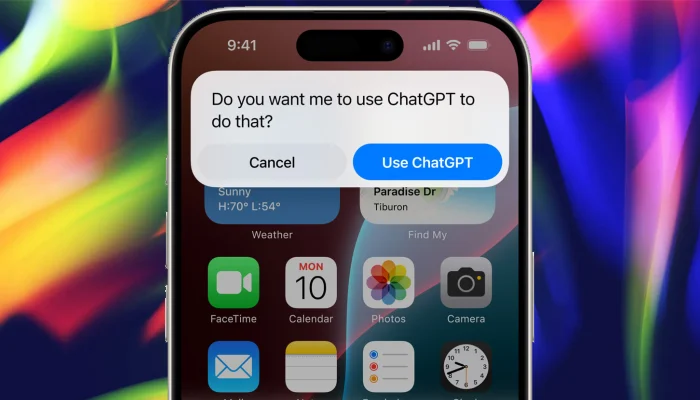

苹果与OpenAI合作,发布新版Siri与生成式AI功能丨马斯克宣布将禁用iPhone丨OpenAI百万年薪挖角谷歌芯片人才

16 2025-02-25

-

华为HDC 2024大会将发布盘古大模型5.0丨谷歌Gemini手机版将迎来多项功能更新丨马斯克xAI计划融资60亿美元

5 2025-04-14

-

苹果WWDC定档6月10日将发布AI战略丨中国时报:苹果与百度尚未达成AI合作丨抖音发布AI数字人治理公告

9 2025-04-18

-

OpenAI CEO奥特曼最新讲话汇总,再次曝光GPT-5细节:性能飞跃超乎想象,低估它的人都会被吓傻

5 2025-04-20 -

李开复:最好的AI大模型已经达到人类平均智商的三倍,“杀手级应用”已经出现

3 2025-04-20

-

重磅!英伟达正式官宣「AI核弹级」芯片B100,性能比H100强两倍的H200将于2024年第二季度出货

3 2025-04-20

-

面对Sora训练数据来源一问三不知!OpenAI遭遇成立以来最为惨烈的公关灾难

4 2025-04-20